Microsoft poursuit des développeurs de deepfakes pour contourner ses garde-fous d’IA - Related to poursuit, nlp, guide, des, garde-fous

Agence IA Générative Doubs (25)

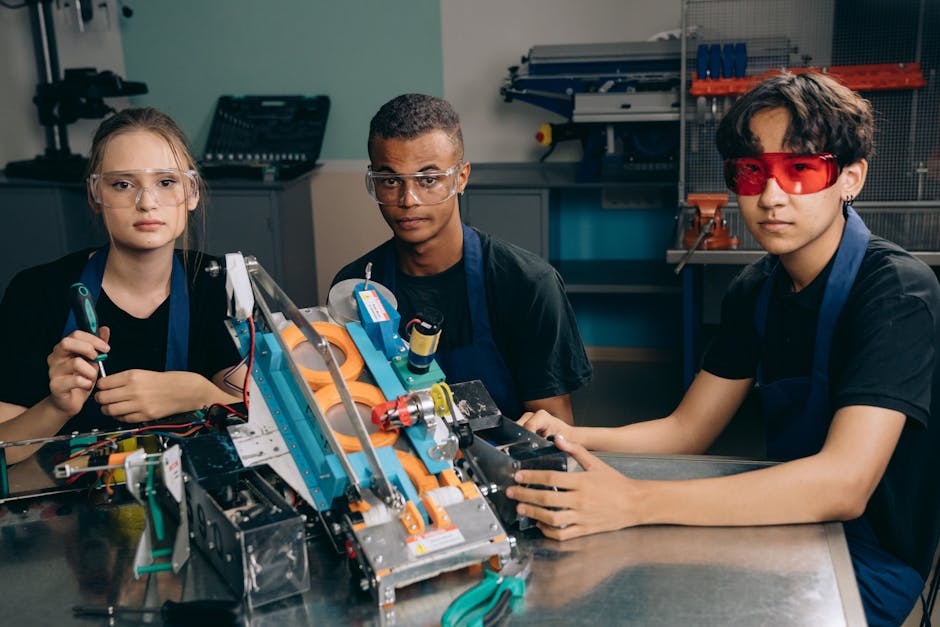

L’essor de l’intelligence artificielle est palpable dans le Doubs, où une nouvelle génération d’agences IA se développe pour répondre aux demandes croissantes des entreprises. Que ce soit pour optimiser les processus, créer des contenus dynamiques ou révolutionner la stratégie commerciale. Les solutions proposées aujourd’hui par les agences IA du Doubs sont variées et prometteuses. Des formations aux experts en passant par des événements dédiés à l’innovation, le Doubs se positionne comme un fleuron de l’IA générative. Apportant un vent de fraîcheur à l’industrie régionale.

L’IA générative n’est plus un simple concept futuriste. Dans le Doubs, elle prend vie grâce à des agences telles que Matsiya et IA Agency. Qui offrent des services spécialisés en création de contenu IA et en intégration d’algorithmes avancés pour les entreprises de toutes tailles. Avec l’importance croissante de l’IA dans le secteur numérique, des initiatives locales telles que le Printemps de l’IA à Besançon sont là pour éclairer et inspirer les esprits créatifs et entrepreneuriaux.

L’importance croissante des agences IA dans le Doubs.

Le développement de solutions d’IA générative dans le Doubs s’accompagne d’une transformation digitale notable. Des entreprises telles qu’Scopeo ont compris le potentiel de l’IA pour transformer les opérations commerciales et stratégiques des entreprises. En effet, ces agences spécialisées accompagnent les entreprises du Doubs dans leur modernisation, en intégrant des technologies d’IA pouvant remplacer et améliorer de nombreuses tâches commerciales routinières.

Comment les agences révolutionnent-elles les entreprises locales ?

Avec la prolifération de l’intelligence artificielle générative. Les entreprises locales voient leurs méthodes de travail transformées. Les services IA proposés dans le Doubs ne se limitent pas à un avenir lointain : ils sont utilisés aujourd’hui pour automatiser les processus. Analyser les tendances du marché et prédire les comportements des consommateurs. Des solutions AI fournies par des entreprises comme Distilia permettent aux sociétés d’être proactives.

Voici une liste des services couramment offerts par les agences IA :

Automatisation des tâches administratives.

Optimisation de la communication clientèle.

Formation et expertise : Élever le niveau de compétence en IA.

Pour tirer parti de l’IA. Il est crucial que les entreprises investissent dans la formation en IA générative. Besançon, en particulier, offre des formations de pointe telles que celles proposées par WegenAI et le programme Midjourney par DATA FORMATION. Ces formations permettent aux individus et aux équipes de comprendre les mécanismes complexes de l’IA et de ses applications pratiques. Un investissement essentiel à l’ère numérique actuelle.

Quels bénéfices pour les entreprises en termes de productivité ?

Les formations en IA dans le Doubs ont un impact direct sur la productivité des entreprises. Les équipes devenues adeptes de l’IA générative appliquent leurs connaissances pour automatiser des tâches à faible valeur ajoutée. Réduisant ainsi les coûts opérationnels et libérant du temps pour des projets à plus forte valeur stratégique. Irisia, par exemple, collabore étroitement avec des entreprises pour améliorer leur performance grâce à la technologie AI.

Un tableau des améliorations communes observées chez les entreprises après une formation en IA est présenté ci-dessous :

Amélioration Impact Automatisation des tâches répétitives Augmentation de l’efficacité de 30% Précision de l’analyse des données Précision accrue de 20% Temps de réponse du service client Réduction de 50% du temps de réponse.

Les événements et collaborations : Catalyseurs de l’innovation IA.

Les événements tels que le Printemps de l’IA à Besançon sont des occasions idéales pour rassembler les passionnés de technologie, les chercheurs. Et les entrepreneurs afin d’échanger sur les avancées de l’IA. Ces rencontres permettent d’explorer de nouvelles collaborations, de concevoir des prototypes d’innovation et de partager les meilleures pratiques autour de l’IA générative 25.

Dans le Doubs. Plusieurs initiatives ont vu le jour pour promouvoir l’utilisation de l’IA. Des projets de recherche conduits par des universités collaborent étroitement avec des sociétés IA pour explorer des applications concrètes de l’IA générative dans la santé. L’automobile ou encore l’administration publique. Un exemple frappant est la fusion de l’ARS Bourgogne Franche-Comté utilisant l’IA pour optimiser ses opérations internes et améliorer l’efficacité dans la région.

L’impact éthique et sociétal de l’IA dans le Doubs.

Alors que l’IA transforme profondément les secteurs économiques. Elle soulève également des questions éthiques cruciales. L’éthique de l’IA générative dans le Doubs est un sujet de discussion central. Les agences comme Amiltone militent pour des pratiques responsables, assurant que la technologie est utilisée de manière éthique et transparente.

Responsabilité et transparence avec l’IA.

Les marques IA dans le Doubs s’engagent à respecter des normes éthiques élevées et à promouvoir la transparence dans l’usage de l’IA. Cela inclut des politiques strictes de gestion des données, des engagements à prévenir les biais des algorithmes. Et des initiatives pour renforcer la confiance des utilisateurs. Ces aspects sont essentiels pour garantir que l’IA générative favorise un développement durable et inclusif, tout en évitant des effets indésirables sur la société. Découvrez comment l’IA repense les interactions sociales et économiques en tenant compte de ces enjeux complexes.

Cloud-based data storage business Snowflake on Thursday revealed its plans to open the Silicon Valley AI Hub, a dedicated space for developers, startu...

In a YouTube video titled Deep Dive into LLMs like ChatGPT, former Senior Director of AI at Tesla. Andrej Karpathy discusses the psychol...

After weeks of waiting, OpenAI has finally introduced , its latest and largest AI language model. It was internally referred to as Orion.

Microsoft poursuit des développeurs de deepfakes pour contourner ses garde-fous d’IA

La lutte contre l’utilisation abusive de l’IA se renforce, alors que Microsoft identifie plusieurs développeurs impliqués dans un réseau criminel. Microsoft intensifie sa lutte contre les cybercriminels. Ceci en poursuivant des développeurs qui ont contourné ses protections IA. Ces derniers ont exploité des services d’IA générative pour créer des contenus illégaux. L’objectif de Microsoft est de démanteler ces réseaux et d’empêcher l’utilisation malveillante de sa technologie.

Un réseau mondial de cybercriminalité identifié.

Microsoft a mis à jour sa plainte en désignant quatre développeurs spécifiques comme étant responsables de la violation de ses garde-fous d’IA. Selon l’entreprise, ces individus faisaient partie du groupe criminel Storm-2139, un réseau global actif dans le piratage et l’exploitation des technologies d’IA. Parmi les accusés, figurent Arian Yadegarnia, Alan Krysiak, Ricky Yuen, et Phát Phùng Tấn, chacun opérant depuis l’Iran, le Royaume-Uni. Hong Kong et le Vietnam.

Ces développeurs ont utilisé des informations d’identification de clients compromis pour accéder illégalement à des comptes fournissant des services d’IA. Après avoir contourné les systèmes de sécurité, ils ont vendu l’accès aux comptes et donné des instructions sur la génération de contenus préjudiciables, notamment des deepfakes de célébrités.

Une action en justice pour stopper les pratiques illégales.

Dans un communiqué. Microsoft a expliqué que sa plainte visait à mettre fin aux pratiques de ces criminels et à démanteler leur réseau. « Nous poursuivons cette action en justice pour dissuader d’autres de tenter de militariser notre technologie d’IA », a déclaré la société. Bien que les quatre développeurs identifiés aient été explicitement mentionnés, Microsoft a précisé qu’il existait d’autres membres impliqués.

Parmi ces autres acteurs, deux résideraient aux États-Unis. Dans l’Illinois et en Floride. Cependant, leurs identités restent confidentielles pour ne pas interférer avec les enquêtes en cours. Microsoft travaille également en collaboration avec les autorités américaines et internationales pour faire face à cette menace croissante.

Perturbation du réseau et divulgation des participants.

Une étape clé de cette enquête a été la saisie d’un site web crucial au fonctionnement de l’opération criminelle. Cette action a non seulement perturbé l’activité illégale, mais a également révélé des informations cruciales sur les membres du groupe. En conséquence, certains membres du réseau se sont retournés contre d’autres. Cela augmente ainsi la complexité de l’enquête.

Cependant, cette saisie a entraîné des réactions violentes, notamment des actes de « doxxing ». Les avocats de Microsoft ont été pris pour cible, leurs informations personnelles et photos publiées en ligne. Microsoft déplore cet aspect de l’affaire, tout en réaffirmant son engagement à poursuivre les responsables de ces pratiques illégales.

Une prise de conscience croissante de l’importance des protections IA.

L’incident met en lumière les défis auxquels Microsoft et d’autres entreprises technologiques sont confrontées pour protéger leurs systèmes d’IA contre les abus. Bien que des garde-fous aient été mis en place, leur efficacité dépend largement de la capacité à appliquer ces protections à l’échelle mondiale.

Microsoft continue de mener des efforts pour renforcer la sécurité et protéger l’intégrité de ses outils d’IA. Ces incidents rappellent l’importance d’une surveillance constante dans le développement et l’utilisation de ces technologies puissantes. Il est désormais crucial de mettre en place des mécanismes de contrôle plus rigoureux pour éviter de nouvelles dérives.

Cloud-based data storage organization Snowflake on Thursday introduced its plans to open the Silicon Valley AI Hub, a dedicated space for developers, startu...

We are looking for writers to propose up-to-date content focused on data science. Machine learning, artificia...

As a general rule, I'm not a huge fan of talking to AI chatbots. Even though many of them sound pretty human, they're still.

NLP : guide complet du traitement du langage naturel

Grâce au Natural Language Processing (NLP), les appareils informatiques peuvent comprendre et traiter le langage humain. Le traitement du langage naturel se porte sur l’interaction entre un humain et un ordinateur. En d’autres termes c’est le point d’intersection entre l’informatique, l’intelligence artificielle et la linguistique informatique.

Les programmes informatiques évoluent de jour en jour pour répondre aux attentes des utilisateurs. Dans la plupart des cas, ces technologies impliquent une interaction homme-machine. Autrement dit, une compréhension mutuelle est nécessaire. Découvrez dans cet article comment le Natural Language Processing permet aux ordinateurs de comprendre et d’agir en fonction du langage humain.

Le NLP, ou traitement du langage naturel en français. Désigne la capacité d’un programme informatique à comprendre le langage humain. Il s’agit d’une composante de l’intelligence artificielle (IA) qui traite le langage naturel tel qu’il est parlé et écrit.

Le Natural Language Processing appartient à la fois au domaine de l’informatique et de la linguistique. Dans le monde réel, il a une variété d’applications dans différents domaines, mais nous y reviendrons plus tard.

Le langage humain est un système complexe. Selon les scientifiques, il s’agit d’un système de signalisation discret, symbolique et catégorique. En d’autres termes, il comprend des symboles qui permettent aux humains de transmettre le même sens de différentes manières. En outre, il existe une infinité de possibilités pour agencer les mots dans une phrase. Un mot peut avoir plusieurs significations en fonction du contexte dans lequel il est placé.

D’autre part. Le langage comporte de nombreuses règles et subtilités difficiles à comprendre pour les ordinateurs. Par exemple, la notion de pluralité ou de sarcasme est difficile à percevoir pour une machine. Cela signifie que pour comprendre le langage humain, le NLP doit comprendre les mots et les différents concepts.

Entre autres. Le NLP traite des données linguistiques du monde réel pour leur donner un sens de manière à ce qu’un ordinateur puisse les comprendre. Pour collecter ces données, les machines utilisent des capteurs (qui correspondent à nos yeux et à nos oreilles) pour lire et entendre.

La compréhension du langage naturel peut se faire par une analyse syntaxique ou une analyse sémantique. L’analyse syntaxique correspond à l’analyse du langage en fonction des règles grammaticales. Elle s’applique donc à un groupe de mots et non aux mots individuels. Quant à l’analyse sémantique, c’est le processus qui permet de comprendre le sens ou à la logique d’un énoncé. Elle consiste donc à comprendre le sens et à interpréter les mots, les signes et la structure des phrases.

En outre. Le traitement se fait par le biais de programmes informatiques en guise de cerveau. Le NLP comporte deux étapes principales, à savoir le prétraitement des données et le développement de l’algorithme.

En termes simples. Cette étape consiste à préparer et à « nettoyer » les données pour que les machines puissent les exploiter. Elle met également en évidence les caractéristiques des textes avec lesquelles un algorithme peut fonctionner.

Il existe différentes approches de NLP pour transformer les données de textes bruts en données exploitables (code). Dans tous les cas, les langages de programmation tels que Python ou R sont très utilisés pour ces techniques. Entre autres, ils disposent de différentes bibliothèques contenant des règles et des méthodes qui permettent aux ordinateurs de classer les segments de textes.

Ce modèle permet de compter les mots d’un texte. Pour ce faire, il crée une matrice d’occurrence pour le document d’entrée, sans tenir compte de la syntaxe ou de la sémantique. Cela permet ensuite de constituer un classificateur des caractéristiques. Toutefois, cette approche ne permet pas de faire une analyse contextuelle ou sémantique de l’entrée.

Cette fois. Le principe consiste à segmenter le texte en phrases ou en mots. Les segments de textes sont appelés « tokens ». Cette approche permet également d’éliminer les caractères tels que les ponctuations ou les émojis.

En NLP. Le stemming est un autre processus de nettoyage des textes. Afin de supprimer les préfixes et les suffixes, il coupe la fin ou le début des mots. La difficulté de cette approche réside dans la détermination des bons morceaux à couper qui nécessite de se référer aux règles.

Similairement au stemming, l’idée est de réduire un mot à sa forme de base. Ou autrement dit à sa racine. Ensuite, les différentes formes d’un même mot sont regroupées. Cette approche nécessite également des dictionnaires détaillés dans lesquels l’algorithme peut rechercher et relier les mots à leurs radicaux. La lemmatisation prend également en compte le contexte du mot pour identifier les différents sens qu’il peut avoir.

Les Stop Words signifient également les mots vides. En d‘autres termes, cette technique du NLP vise à supprimer les articles, les pronoms et les prépositions. Elle permet de libérer de l’espace dans la base de données et d’accélérer le temps de traitement.

Cette approche présume que chaque document se compose d’un mélange de sujets. Dans ce cas, chaque sujet comprend un ensemble de mots. La modélisation thématique consiste à découvrir les structures cachées dans les contenus.

Cette technique se révèle particulièrement utile lorsqu’il s’agit de classer des textes. En outre, elle permet de construire des systèmes de recommandation ou de détecter des tendances dans les publications en ligne.

La phase d’apprentissage (développement de l’algorithme de NLP).

Une fois que les données sont prétraitées. La prochaine étape du NLP consiste à développer un algorithme pour les interpréter. Là encore, il existe de nombreux algorithmes de Natural Language Processing. Cependant, il y a trois types d’approches couramment utilisées.

Ici, il est question de règles linguistiques élaborées spécifiquement pour un domaine. Celles-ci permettent de résoudre des problèmes assez simples, comme extraire des données structurées à partir de données non structurées. Par exemple, cette technique permet de classer les mails indésirables dans les spams. Dans ce cas, la règle serait de filtrer des termes spécifiques comme « offres » ou « promotion ».

La méthode basée sur le machine learning.

Le machine learning consiste à alimenter un système avec des données d’entraînement pour apprendre par lui-même à effectuer une tâche. À mesure que l’algorithme apprend et qu’il reçoit des données à traiter, il améliore ses performances.

En termes de NLP. Cette approche permet de résoudre des problèmes plus difficiles. Plus axée dans la compréhension du langage que la méthode basée sur les règles, les algorithmes de machine learning exploitent les données prétraitées. Par ailleurs, grâce à leur capacité d’apprentissage automatique, ils peuvent également se référer à la longueur des phrases ou à l’occurrence de mots spécifiques. Généralement, ils utilisent des méthodes statistiques.

À la différence du machine learning traditionnel, le deep learning. Qui en est une sous-catégorie, utilise plusieurs couches de réseaux neuronaux. Ceux-ci peuvent servir d’extracteurs automatiques des caractéristiques, ce qui signifie que cette méthode ne nécessite pas un prétraitement complexe. Étant plus puissants, les algorithmes de deep learning permettent alors d’effectuer des tâches qui sont encore plus difficiles, comme la traduction.

Le point commun entre ces deux dernières méthodes est qu’elles peuvent affiner leurs propres règles grâce à un apprentissage itératif.

Il est significant de noter que ce concept n’est pas récent. En effet, ses prémices remontent aux années 1940, avec les premières tentatives de créer des représentations mathématiques du cerveau humain. Toutefois, cette branche de l’intelligence artificielle ne fut propulsée au premier plan que dans les années 2000. Elle a trouvé sa voie avec l’essor de la puissance de calcul des ordinateurs et de l’accès aux données massives ou big data.

Les travaux pionniers de chercheurs comme Yann LeCun ont été cruciaux pour le développement de cette approche. Aujourd’hui, le deep learning étend son influence à de nombreux domaines d’application tels que la médecine, l’automobile, le marketing, la reconnaissance faciale et vocale. Il est également utile dans le traitement du langage naturel et dans la robotique. Il est capable de traiter efficacement d’énormes volumes de données et de générer des solutions intelligentes. Ainsi, il ne cesse de repousser les frontières de l’IA.

Cette approche inspirée par le fonctionnement du cerveau humain a engendré une véritable révolution dans le domaine technologique. Elle se sert de réseaux de neurones artificiels pour créer des systèmes capables d’apprendre, de prévoir et de décider avec une certaine autonomie. Les algorithmes sophistiqués du deep learning visent à atteindre des performances remarquables.

Les secteurs d’application de l’intelligence artificielle dans notre vie quotidienne sont quasiment illimités. De ce fait, en tant que technologie reliée à l’IA, le NLP peut aider dans de nombreuses tâches.

La traduction automatique est l’une des premières applications du NLP. Il existe quatre types de traduction automatique basés sur le Natural Language Processing.

La traduction automatique statistique dépend de l’étude de données bilingues pour trouver une correspondance entre le mot de la langue d’entrée et celui de la langue souhaitée. La traduction automatique basée sur les règles traduit les textes en se basant sur les règles grammaticales des deux langues.

La traduction automatique hybride combine en quelque sorte les deux méthodes précédentes. Et elle utilise une mémoire de traduction. Enfin, la traduction automatique neuronale s’appuie sur des modèles de réseaux de neurones artificiels pour créer des modèles statistiques. C’est par exemple le cas de DeepL qui se base sur le deep learning pour une traduction automatique naturelle.

Le NLP dans le domaine de la santé et de la médecine.

Entre autres domaines d’applications du NLP. La médecine est sans doute l’un des plus importants. En effet, le traitement du langage naturel permet de reconnaître ou prédire des maladies en se basant sur les dossiers médicaux électroniques (DME) et le discours d’un patient.

La technologie est actuellement utilisée pour diagnostiquer les maladies cardiovasculaires. La dépression ou encore la schizophrénie. Pour être plus précis, le NLP extrait les informations nécessaires sur la maladie, les médicaments et les résultats des traitements. Comme source de données, il se base sur les notes des patients, les rapports ou les DME. En outre, la surveillance des troubles cognitifs de la parole permet également d’améliorer le traitement de la maladie d’Alzheimer. D’autre part, il existe des dispositifs, comme les chatbots thérapeutes qui aident les personnes qui souffrent d’anxiété.

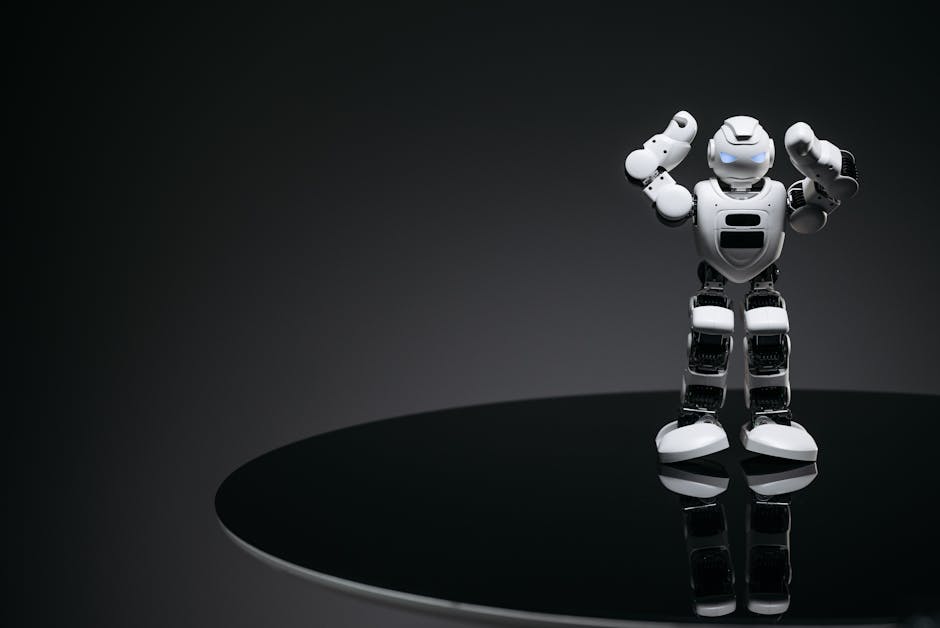

Les agents conversationnels, tels que les chatbots et les assistants vocaux. Sont des exemples qui reflètent parfaitement la capacité des programmes informatiques à comprendre le langage humain. Par exemple, un chatbot est une plateforme qui permet aux clients d’une entreprise de commander des services ou de demander des informations. Par définition, le robot conversationnel reçoit donc une entrée en langage naturel et le NLP lui permet d’interpréter cette information.

De la même manière. Les assistants vocaux et les robots assistants reçoivent des entrées vocales. Ces systèmes utilisent le Natural Language Processing pour répondre aux commandes et agir en fonction. En d’autres termes, c’est la compréhension du langage humain qui permet par exemple à Alexa d’allumer la lumière, sur commande.

L’analyse des tendances en ligne grâce au NLP.

Pour les entreprises commerciales. L’utilisation des algorithmes de NLP permet d’identifier les avis des clients sur un service ou un produit. Pour ce faire, il peut, par exemple, extraire des informations à partir des médias sociaux. Cette technique est également connue comme l’analyse des sentiments et elle est utilisée pour prendre des décisions commerciales stratégiques en se basant sur le choix des clients.

Un autre aspect de cette utilisation du NLP concerne les traders financiers. En effet, il permet de suivre les nouvelles, les taux d’inflation ou les rapports. La combinaison de ces informations avec les algorithmes de trading s’avère être une bonne tactique pour générer des bénéfices.

Utiliser le NLP pour détecter les fake news.

Le traitement du langage naturel a été utilisé par le NLP Group du MIT pour vérifier l’authenticité d’une source d’informations. Une autre utilisation que nous avons déjà évoquée est aussi l’analyse des courriers électroniques. Effectivement, certaines sociétés comme Yahoo et Google utilisent cette technologie pour stopper les spams avant même qu’ils n’entrent dans la boîte de réception.

Les algorithmes de NLP peuvent aider les entreprises à automatiser des tâches de routines liées à l’analyse de texte. D’autre part, les organismes de recrutement utilisent l’intelligence artificielle pour repérer des candidats potentiels. Autrement dit, le traitement du langage naturel permet d’analyser les dossiers de candidatures pour identifier les compétences clés.

Le principal avantage du NLP est qu’il améliore la façon dont les humains et les ordinateurs communiquent entre eux. Pour manipuler un programme informatique, le moyen le plus direct passe par le code, le langage de l’ordinateur. En autorisant les machines à comprendre le langage humain, l’interaction avec celles-ci devient beaucoup plus intuitive pour les humains.

En outre. Les données non structurées nécessitent un niveau d’analyse supplémentaire. Il faut ainsi les décomposer pour qu’il puisse être compris par les machines. Mais les outils NLP guidés par l’IA peuvent faciliter cette tâche. Fini les conjectures ou les analyses simples et superficielles. Le traitement du langage naturel permet de creuser dans le texte non structuré pour obtenir des informations exploitables.

Un fonctionnement plus efficace signifie une productivité accrue. Qu’il s’agisse de répondre aux demandes des clients ou d’ingérer des données client, la PNL réduit les coûts. L’IA d’entreprise peut traiter les données plus rapidement avec des informations plus significatives qui améliorent l’expérience client.

Amélioration de la précision et de l’efficacité de la documentation ;

Réalisation automatique d’un résumé lisible d’un texte original plus vaste et plus complexe ;

Utilisation d’assistants personnels et de chatbots ;

Analyse des sentiments facile à réaliser ;

Mise à disposition d’informations avancées à partir d’analyses qui n’étaient pas disponibles auparavant en raison du volume de données.

Les différentes techniques utilisées avec le NLP.

L’analyse syntaxique et l’analyse sémantique constituent les deux principales techniques utilisées pour le NLP.

La syntaxe désigne la disposition des mots dans une phrase pour lui donner un sens grammatical. Le NLP l’utilise pour évaluer le sens d’une langue sur la base de règles grammaticales. Les techniques syntaxiques comprennent :

L’analyse syntaxique . Il s’agit de l’analyse grammaticale d’une phrase.

Segmentation des mots . Il s’agit de prendre une chaîne de texte et d’en déduire des formes de mots.

La séparation des phrases . Il s’agit de placer des limites de phrases dans des textes volumineux.

Segmentation morphologique . Elle divise les mots en partie plus petits appelés morphèmes.

L’étymologie . Cette opération consiste à diviser les mots contenant une inflexion en formes racines.

La sémantique concerne l’utilisation et le sens des mots. Le traitement du langage naturel applique des algorithmes pour comprendre le sens et la structure des phrases. Les techniques sémantiques comprennent :

La désambiguïsation du sens des mots . Cette technique permet de déduire la signification d’un mot en fonction du contexte.

Reconnaissance d’entités nommées . Cette méthode détermine les mots qui peuvent être classés en groupes.

Génération de langage naturel . Cette méthode utilise une base de données pour déterminer la sémantique des mots et générer un nouveau texte.

Les approches actuelles du traitement du langage naturel sont basées sur le deep learning. Il s’agit d’un type d’IA qui examine et utilise des modèles dans les données pour améliorer la compréhension d’un programme.

Natural Language Toolkit (NLTK) : Bibliothèque Python open source contenant des ensembles de données, des algorithmes de traitement linguistique et des didacticiels.

spaCy : Bibliothèque Python performante pour le NLP, utilisée pour le tokenisation, la reconnaissance d’entités nommées et l’analyse de dépendances syntaxiques.

Gensim : Bibliothèque spécialisée dans la modélisation de sujets, l’indexation de documents et le calcul de similitudes entre textes.

Transformers de Hugging Face : Bibliothèque permettant l’utilisation et le déploiement de modèles pré-entraînés tels que BERT et GPT. Facilitant l’implémentation d’applications NLP complexes.

Intel NLP Architect : Bibliothèque Python dédiée aux topologies d’apprentissage profond et aux applications NLP avancées, optimisée pour les environnements Intel.

Les défis à relever dans le domaine du NLP.

Le traitement du langage naturel présente un certain nombre de défis. La plupart d’entre eux se résument au fait que celui-ci est en constante évolution et toujours quelque peu ambigu. En voici quelques-uns.

Les ordinateurs ont généralement besoin que les humains leur « parlent » dans un langage de programmation précis. Sans ambiguïté et très structuré. Le langage humain, cependant, n’est pas toujours précis. En effet, il est souvent ambigu et la structure linguistique peut dépendre de nombreuses variables complexes. Notamment l’argot, les dialectes régionaux et le contexte social.

Le traitement du langage naturel est loin d’être parfait. Les analyses sémantiques, par exemple, peuvent encore constituer un défi. D’autres difficultés incluent le fait que l’utilisation abstraite du langage est généralement difficile à comprendre pour les programmes. Ainsi, le traitement du langage naturel ne capte pas facilement le sarcasme. Ces sujets nécessitent généralement de comprendre les mots utilisés et leur contexte dans une conversation.

De même. Une phrase peut changer de sens selon le mot ou la syllabe sur lesquels le locuteur met l’accent. Lors de la reconnaissance vocale, les algorithmes de la NLP peuvent passer à côté des changements subtils, mais importants. Du ton de la voix d’une personne. Le ton et l’inflexion de la parole peuvent également varier selon les accents, ce qui peut être difficile à analyser pour un algorithme.

Le traitement du langage naturel rencontre également des difficultés du fait que le langage — et la façon dont les gens l’utilisent — évolue en permanence. Bien qu’il existe des règles du langage, ces dernières sont susceptibles de changer au fil du temps. Les règles informatiques strictes qui fonctionnent aujourd’hui peuvent devenir obsolètes au fur et à mesure que les caractéristiques du langage du monde réel évoluent.

En somme. Le traitement du langage naturel est un élément clé de l’intelligence artificielle. Sans ce concept, les ordinateurs ne pourraient pas comprendre les humains et par conséquent, ne pourraient pas interagir avec eux.

Pour en savoir davantage sur le fonctionnement et l’utilisation du NLP, voici quelques références :

Les meilleurs cas d’utilisation des chatbots NLP en 2025.

En raison de leur flexibilité. Les chatbots nlp s’adaptent à une grande variété de contextes, des solutions d’entreprise aux assistants d’intelligence artificielle pour petites sociétés. Ces technologies trouvent leur application dans plusieurs secteurs clés en 2025.

Les services financiers intègrent ces outils pour améliorer leur relation client. Le domaine immobilier utilise aussi ces assistants virtuels afin de faciliter la recherche de biens. Dans l’éducation, ces chatbots deviennent des ressources précieuses pour l’apprentissage. Les hôtels et restaurants, quant à eux, ils les emploient pour les réservations et le service client.

Grâce à NLP. Le secteur des soins de santé bénéficie de leur assistance pour la prise de rendez-vous et l’information des patients. Les compagnies d’assurance améliorent également leur gestion des réclamations grâce à cette technologie. Il en est de même pour les compagnies aériennes qui sont capables d’optimiser leur service client et la gestion des réservations avec l’usage de ce chatbot.

Enfin. Les administrations gouvernementales utilisent ces outils pour faciliter l’accès aux informations flexibilité conversationnelle de ces chatbots NLP permet à ces opérateurs de s’adapter à tout contexte d’échange. Ils offrent des possibilités de personnalisation variées, comme l’animation d’un jeu de rôle Donjons et Dragons, l’aide aux devoirs de mathématiques ou la fonction de guide dans différents domaines.

In October last year, Walmart revealed its plans around AI. AR, and immersive commerce experiences. This led to the introduction of Wallaby, a collect...

Le quantum computing est une révolution du domaine informatique. Cette technologie émergente repose sur la mécanique quantique pour la conception de n...

Market Impact Analysis

Market Growth Trend

| 2018 | 2019 | 2020 | 2021 | 2022 | 2023 | 2024 |

|---|---|---|---|---|---|---|

| 23.1% | 27.8% | 29.2% | 32.4% | 34.2% | 35.2% | 35.6% |

Quarterly Growth Rate

| Q1 2024 | Q2 2024 | Q3 2024 | Q4 2024 |

|---|---|---|---|

| 32.5% | 34.8% | 36.2% | 35.6% |

Market Segments and Growth Drivers

| Segment | Market Share | Growth Rate |

|---|---|---|

| Machine Learning | 29% | 38.4% |

| Computer Vision | 18% | 35.7% |

| Natural Language Processing | 24% | 41.5% |

| Robotics | 15% | 22.3% |

| Other AI Technologies | 14% | 31.8% |

Technology Maturity Curve

Different technologies within the ecosystem are at varying stages of maturity:

Competitive Landscape Analysis

| Company | Market Share |

|---|---|

| Google AI | 18.3% |

| Microsoft AI | 15.7% |

| IBM Watson | 11.2% |

| Amazon AI | 9.8% |

| OpenAI | 8.4% |

Future Outlook and Predictions

The Agence Générative Doubs landscape is evolving rapidly, driven by technological advancements, changing threat vectors, and shifting business requirements. Based on current trends and expert analyses, we can anticipate several significant developments across different time horizons:

Year-by-Year Technology Evolution

Based on current trajectory and expert analyses, we can project the following development timeline:

Technology Maturity Curve

Different technologies within the ecosystem are at varying stages of maturity, influencing adoption timelines and investment priorities:

Innovation Trigger

- Generative AI for specialized domains

- Blockchain for supply chain verification

Peak of Inflated Expectations

- Digital twins for business processes

- Quantum-resistant cryptography

Trough of Disillusionment

- Consumer AR/VR applications

- General-purpose blockchain

Slope of Enlightenment

- AI-driven analytics

- Edge computing

Plateau of Productivity

- Cloud infrastructure

- Mobile applications

Technology Evolution Timeline

- Improved generative models

- specialized AI applications

- AI-human collaboration systems

- multimodal AI platforms

- General AI capabilities

- AI-driven scientific breakthroughs

Expert Perspectives

Leading experts in the ai tech sector provide diverse perspectives on how the landscape will evolve over the coming years:

"The next frontier is AI systems that can reason across modalities and domains with minimal human guidance."

— AI Researcher

"Organizations that develop effective AI governance frameworks will gain competitive advantage."

— Industry Analyst

"The AI talent gap remains a critical barrier to implementation for most enterprises."

— Chief AI Officer

Areas of Expert Consensus

- Acceleration of Innovation: The pace of technological evolution will continue to increase

- Practical Integration: Focus will shift from proof-of-concept to operational deployment

- Human-Technology Partnership: Most effective implementations will optimize human-machine collaboration

- Regulatory Influence: Regulatory frameworks will increasingly shape technology development

Short-Term Outlook (1-2 Years)

In the immediate future, organizations will focus on implementing and optimizing currently available technologies to address pressing ai tech challenges:

- Improved generative models

- specialized AI applications

- enhanced AI ethics frameworks

These developments will be characterized by incremental improvements to existing frameworks rather than revolutionary changes, with emphasis on practical deployment and measurable outcomes.

Mid-Term Outlook (3-5 Years)

As technologies mature and organizations adapt, more substantial transformations will emerge in how security is approached and implemented:

- AI-human collaboration systems

- multimodal AI platforms

- democratized AI development

This period will see significant changes in security architecture and operational models, with increasing automation and integration between previously siloed security functions. Organizations will shift from reactive to proactive security postures.

Long-Term Outlook (5+ Years)

Looking further ahead, more fundamental shifts will reshape how cybersecurity is conceptualized and implemented across digital ecosystems:

- General AI capabilities

- AI-driven scientific breakthroughs

- new computing paradigms

These long-term developments will likely require significant technical breakthroughs, new regulatory frameworks, and evolution in how organizations approach security as a fundamental business function rather than a technical discipline.

Key Risk Factors and Uncertainties

Several critical factors could significantly impact the trajectory of ai tech evolution:

Organizations should monitor these factors closely and develop contingency strategies to mitigate potential negative impacts on technology implementation timelines.

Alternative Future Scenarios

The evolution of technology can follow different paths depending on various factors including regulatory developments, investment trends, technological breakthroughs, and market adoption. We analyze three potential scenarios:

Optimistic Scenario

Responsible AI driving innovation while minimizing societal disruption

Key Drivers: Supportive regulatory environment, significant research breakthroughs, strong market incentives, and rapid user adoption.

Probability: 25-30%

Base Case Scenario

Incremental adoption with mixed societal impacts and ongoing ethical challenges

Key Drivers: Balanced regulatory approach, steady technological progress, and selective implementation based on clear ROI.

Probability: 50-60%

Conservative Scenario

Technical and ethical barriers creating significant implementation challenges

Key Drivers: Restrictive regulations, technical limitations, implementation challenges, and risk-averse organizational cultures.

Probability: 15-20%

Scenario Comparison Matrix

| Factor | Optimistic | Base Case | Conservative |

|---|---|---|---|

| Implementation Timeline | Accelerated | Steady | Delayed |

| Market Adoption | Widespread | Selective | Limited |

| Technology Evolution | Rapid | Progressive | Incremental |

| Regulatory Environment | Supportive | Balanced | Restrictive |

| Business Impact | Transformative | Significant | Modest |

Transformational Impact

Redefinition of knowledge work, automation of creative processes. This evolution will necessitate significant changes in organizational structures, talent development, and strategic planning processes.

The convergence of multiple technological trends—including artificial intelligence, quantum computing, and ubiquitous connectivity—will create both unprecedented security challenges and innovative defensive capabilities.

Implementation Challenges

Ethical concerns, computing resource limitations, talent shortages. Organizations will need to develop comprehensive change management strategies to successfully navigate these transitions.

Regulatory uncertainty, particularly around emerging technologies like AI in security applications, will require flexible security architectures that can adapt to evolving compliance requirements.

Key Innovations to Watch

Multimodal learning, resource-efficient AI, transparent decision systems. Organizations should monitor these developments closely to maintain competitive advantages and effective security postures.

Strategic investments in research partnerships, technology pilots, and talent development will position forward-thinking organizations to leverage these innovations early in their development cycle.

Technical Glossary

Key technical terms and definitions to help understand the technologies discussed in this article.

Understanding the following technical concepts is essential for grasping the full implications of the security threats and defensive measures discussed in this article. These definitions provide context for both technical and non-technical readers.

large language model intermediate

algorithm intermediate

machine learning intermediate

deep learning intermediate

platform intermediate

NLP intermediate

API beginner

How APIs enable communication between different software systems

How APIs enable communication between different software systems